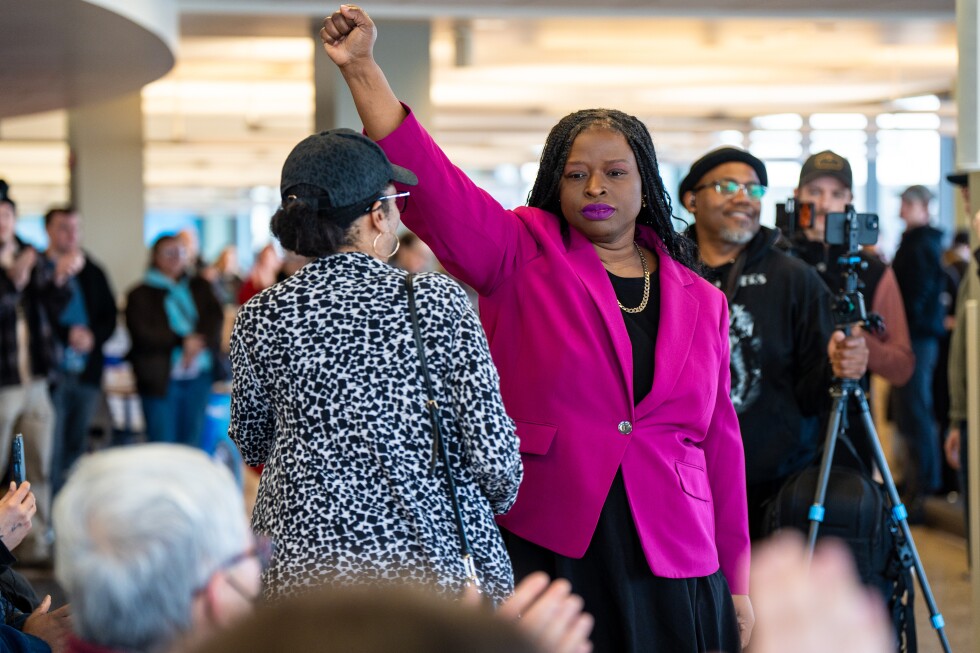

近日,一张关于民权律师Nekima Levy Armstrong在被捕后落泪的AI合成图像在社交媒体上引发轩然大波。尽管原始照片显示的是她坚定的抗议姿态,但经过深度伪造(Deepfake)处理后的版本却被官方相关账号传播,这标志着人工智能在政治叙事中的应用达到了一个令人警惕的新高度。

这一事件并非孤例。自边境执法部门发生致命枪击事件后,关于移民和海关执法局(ICE)的AI编辑图像和视频在网络上呈爆炸式增长。然而,当修改后的图像由具有公信力的政治实体发布时,其影响远超普通网络迷因(Meme)。康奈尔大学信息科学教授David Rand指出,将此类操纵媒体定性为“迷因”,是试图用幽默外衣为其辩护,从而规避对传播虚假信息的批评。

技术传播顾问Zach Henry分析,这类高度拟真的AI内容是针对“深度在线”(terminally online)核心支持群体的精准投放策略。对于熟悉网络文化的受众,这是一种内部代码;而对于不熟悉网络语境的群体,其逼真外观足以引发质疑和讨论,从而助推病毒式传播。

西北大学教授Michael A. Spikes强调,政府机构的职责是提供准确、可验证的信息。当官方渠道主动参与创造和传播非真实内容时,它正在“固化一种事件的观念,而非展示事件的实际发生情况”,这直接侵蚀了公众对联邦机构信息准确性的基本信任。

UCLA教授Ramesh Srinivasan进一步担忧,AI系统的普及将加剧信任缺失的危机,模糊了现实、真相与证据之间的界限。更令人担忧的是,当拥有公信力的角色(如政策制定者)分享未经标记的合成内容时,这无异于为普通用户和利益相关者“开了绿灯”,鼓励他们散布更多未经证实的合成媒体。

专家们观察到,社交媒体平台对极端和阴谋论内容的算法偏好,与AI工具的易用性相结合,正在形成一个“巨大的挑战集合”。目前充斥在网络上的大量关于ICE执法的虚假视频,尽管可能源于“点击诱饵”(engagement farming),但它们满足了部分群体“一厢情愿的想象”(wishful thinking)。

内容创作者Jeremy Carrasco指出,大多数普通用户难以分辨真伪,尤其是在高风险情境下。即使存在路标文字错乱等AI生成痕迹,也只有最警觉的观众才能识别。他认为,内容溯源技术,如C2PA联盟推动的数字水印系统,可能是解决方案,但普及尚需时日。

总结而言,AI合成图像的政治化使用,不再是边缘现象,而是正在成为主流信息战的工具。正如Carrasco所言:“这问题将永远存在下去”,数字真实性的危机已成为我们信息生态的长期结构性挑战。(来源:基于美联社报道分析整理)